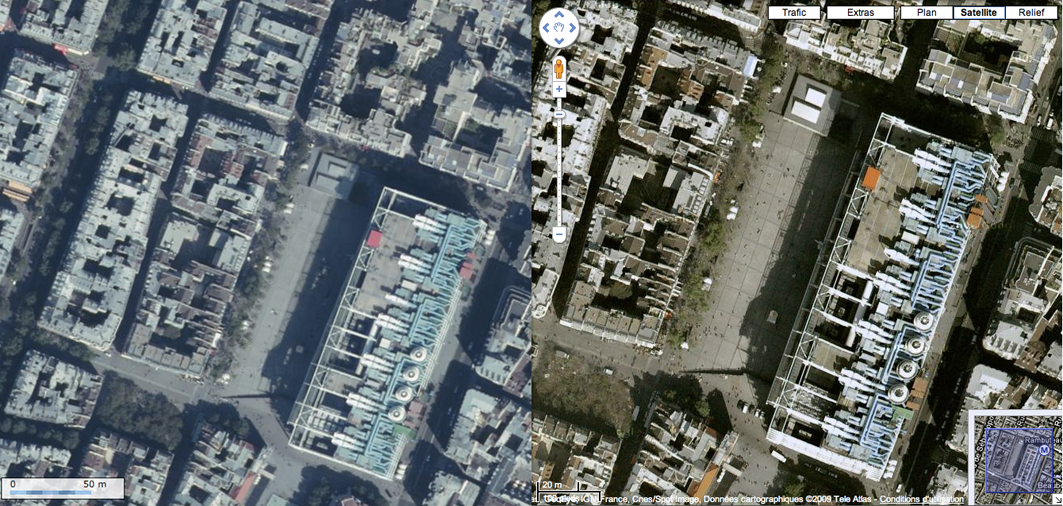

Fig. 1 - Comparaison de Geoportail (gauche) et de Google Map (droite) - Paris centre - décembre 2009

« Le besoin de localiser justifie la carte. Mais constamment brandie, cette image est donnée pour la réalité acquérant finalement un statut usurpé : celui de preuve. »

Denis Retaillé. 1996. « La vérité des cartes », in Le débat, no92.

Ces cinq dernières années, les pratiques cartographiques ont été profondément renouvelées et se sont en grande partie concentrées au sein des grandes métropoles. La carte y était généralement présente dans le métro, dans la rue (mobilier urbain) ou dans les guides. Elle est à présent sur Internet et par continuité sur les téléphones mobiles adaptés, accompagnant les individus dans leurs déplacements. Augmentée des moyens de l’égocentrer, de la télécommuniquer et de la coproduire, la carte devient un objet plus complexe, dont le rôle et la responsabilité ont changé. Considérer le rôle de la carte, son évolution récente et les enjeux correspondants permet de prendre la mesure des opportunités et des défis de l’environnement urbain contemporain. La carte est plus que jamais une remarquable technique spatiale qui peut être mobilisée avantageusement dans la mobilité et dans l’aménagement des espaces les plus complexes. Ainsi augmentée, la carte a cependant rarement autant entretenu l’illusion de son analogie avec l’espace dont elle est la représentation, au risque de façonner la ville à son image, aussi trompeuse soit-elle.

La ville est un espace particulièrement intense. Il se distingue par sa densité, sa diversité et plus généralement par sa capacité à maximiser l’interaction sociale [Claval, 1981, p.4]. L’option qui consiste à rassembler de nombreuses réalités sur une faible étendue se traduit néanmoins par une compacité qui nuit non seulement à la visibilité de ses potentialités, mais aussi à sa fluidité, se traduisant par une distance interne d’autant plus importante qu’elle encourage le contact en son sein. Ce paradoxe apparent de l’urbanisation des pratiques souligne la capacité créative de l’espace urbain, qui ne se résume pas à la réalisation d’interactions qui auraient de toute façon lieu par ailleurs. La ville, par l’intensité des échanges qui peuvent s’y déployer, est un remarquable catalyseur de l’innovation. Elle initie continuellement de nouvelles intentionnalités et suscite des problématiques spatiales sans cesse renouvelées.

Cette spécificité de l’espace urbain explique pourquoi la télécommunication n’a jamais été un obstacle à son développement, mais au contraire un moyen d’en renforcer l’attractivité. La ville, comme les moyens de transport ou les moyens de transmission, répond à un objectif essentiel : créer du contact où il y aurait de l’écart. En cela, les intentionnalités spatiales ne sont pas un stock défini d’actions qui n’attendraient que d’être actualisées. Elles sont sans stimulées et accrues par le développement de la ville, comme par celui des moyens de communication.

C'est pourquoi la télécommunication n’est pas une alternative à la ville, mais un moyen de la rendre encore plus efficiente. Sa limite, évidente, est de ne pas pouvoir être habitée par les corps et plus généralement par la matière. Il faut bien être quelque part ! Un débat comparable apparut avec le développement du train ou de l’automobile, confondant les moyens et le territoire du contact. La conviction fut suffisante pour disperser l’habitat, en sacrifiant non seulement la ville, mais aussi l’interaction sociale et la possibilité de mutualiser les services rares (écoles, hôpitaux, bibliothèques, etc.).

De surcroît, la télécommunication autorise certes des vitesses considérables, mais elle se limite aux échanges immatériels. Il n’est pas surprenant de constater que la ville, qui est l’espace privilégié de l’interaction sociale et de l’innovation, soit aussi l’espace qui tire le plus profit de la télécommunication [Castells, 1989] et d’Internet en particulier. C’est tant la résistance des espaces les plus urbanisés [Sassen, 2000] que la concentration des TIC en leur sein [Castells, 2002 Zook, 2005] qui est constatée. « Le téléphone apparaît ainsi non comme un substitut, mais comme un outil de maîtrise par le citadin de son environnement urbain social et pratique », résumait François Ascher pour souligner la logique complémentaire et non substitutive de la ville et de la télécommunication [Ascher, 1995].

Manuel Castells a montré à quel point la ville est un espace complexe, qui articule finement l’espace des flux et l’espace des lieux. Bien qu’il décrivit la ville comme l’espace privilégié des flux, il rappela dès 1996 que la ville est aussi un espace de lieux [Castells, 1996]. Cet espace des lieux est non seulement la dimension architecturale de la ville, mais plus généralement le fait que les individus vivent « dans des lieux donnés et ont donc une perception de leur espace localisée » [Castells, 1996 ? Pflieger, 2006, p. 324], « un espace dont le sens primordial est centré sur la valorisation de la localité » [Pflieger, 2006, p. 266].

La ville est précisément cet espace complexe, fait de flux et de lieux, qui en assurent la qualité et la pertinence comme espace privilégié de la coexistence. C’est pourquoi, pour souligner cette propriété singulière de la ville, Jacques Lévy la définit comme un « géotype de substance sociétale fondé sur la coprésence » [Lévy, 2004], une option spatiale qui privilégie la densité et la diversité, une option pour laquelle la mobilité et la télécommunication sont des moyens de la mise en contact et non de la mise à distance.

L’espace est en cela autant une contrainte (obstacle à l’interaction, friction de la distance) qu’une liberté (liberté de mouvement, diversité des espaces de l’action) et la ville apparaît comme un espace des possibles. Un espace dont les virtualités ont besoin de la carte pour être lisibles et pour se réaliser. L’évolution de la carte, télécommuniquée et mobilisée lors des déplacements, est en cela tout autant l’évolution de la ville. La carte n’est plus tout à fait la même, la ville non plus. En transformant la carte, c’est la ville que nous changeons.

La carte accroît notre potentiel d’action en créant des analogies entre nos représentations spatiales et l’espace de nos représentations, entre nos intentions spatiales et l’espace de nos intentions. Le renouvellement de la carte, sa numérisation, son automatisation, son auto-localisation, sa personnalisation et sa télécommunication posent ainsi de nombreux défis, qui engagent à s’assurer de la qualité du contexte de production de ces analogies. Sans une telle précaution, ce n’est pas seulement la carte qui serait pervertie, mais la ville dans son ensemble, ainsi que ceux qui l’habitent.

La ville et la carte sont en effet deux espaces qui répondent à des problématiques distinctes. Le premier est un agencement spatial singulier qui a vocation à maximiser l’interaction sociale, le second est un espace figuré utile à la représentation d’autres espaces. Rappeler que l’espace de la carte n’est pas l’espace de la ville qu’elle représente est trivial et pourtant essentiel à la compréhension de quelques enjeux de la cartographie contemporaine. Cette dissociation des deux logiques permet aussi de mieux comprendre dans quelles perspectives particulières la ville et la carte se rencontrent, sans se confondre.

L’usage de la carte dans le contexte spécifiquement urbain [Fisher, 2007] connaît en effet un renouveau important, dont les incidences sur les virtualités de la ville sont considérables. L’urbanisation croissante de l’espace habité, seule, ne suffit pas à justifier l’attention accrue dont la carte fait l’objet ces dernières années. Cette tendance fut assuré par la convergence de plusieurs technologies plus anciennes, toutes mobilisées pour rendre la carte plus efficiente.

En l’espace de cinq ans, les acteurs qui ont contribué au renouveau de la cartographie1 ont associé étroitement le potentiel de l’automatisation de la représentation (SIG), de l’automatisation de la localisation (GPS) et de la télécommunication des données (Internet). En cela, il n’est pas surprenant de constater que le téléphone mobile, objet ultime de cette convergence, est devenu en moins de cinq ans l’interface privilégiée d’accès à l’information géographique2.

Si l’on considère l’offre pléthorique de services relatifs à l’information spatiale (navigation automobile, cartographie locale, réseaux sociaux3, « réalité augmentée »4, etc.), il est aisé d’identifier le potentiel offert par de tels dispositifs. Leur usage, encore marginal, doit en grande partie à la diffusion récente de ce type d’offres et à l’immaturité de nombreux services, dont la dispersion, la redondance et l’inadéquation chronique avec la demande n’assurent pas une visibilité suffisante.

En revanche, il importe de garder à l’esprit que Google Map, un des services qui a activement contribué à la diffusion de la cartographie auprès d’un large public, fut lancé en 2004 aux États-Unis et seulement en 2006 en France. L’iPhone, qui a « popularisé » ce type de service dans le contexte de la mobilité, fut quant à lui lancé il y a moins de 3 ans. Malgré la jeunesse de ces innovations, il est néanmoins possible de dégager quelques grandes lignes de ce que ces dispositifs font à la carte, tant le renouveau ne se résume pas à une transposition du papier à l’écran.

Une des innovations importantes de cette convergence, probablement la plus récente, est l’auto-localisation du dispositif de consultation. Qu’il s’agisse de l’ordinateur ou du téléphone mobile, les technologies de géolocalisation ont récemment connu d’importants progrès, au point de développer des technologies spécifiquement adaptées à la ville. Les technologies de géolocalisation, initialement à vocation militaire (GPS), n’étaient pas destinées à l’environnement urbain. Les téléphones mobiles actuels utilisent donc une combinaison de techniques complémentaires, chacune adaptée à la diversité des configurations (rue étroite, espace intérieur, périurbain, etc.) dont essentiellement le Cell-ID et le WiFi5.

Le succès de la géolocalisation peut surprendre, tant il se résume à donner une information relativement simple, particulièrement en environnement urbain. C’est surtout l’automatisation du processus qui intéresse, tant elle autorise une multitude de pratiques6 qui, autrement, seraient fastidieuses au point de demeurer marginales.

Au-delà de la navigation automobile, qui en est l’archétype, la multitude d’applications qui utilisent les coordonnées (se repérer, chercher un restaurant ou des toilettes publiques, etc.) se retrouve dans un environnement cohérent dont l’affordance s’impose peu à peu comme une évidence : mon téléphone, qui m’accompagne, sait où je suis ! En évitant la redondance, l’acte est plus spontané, simplifié. C’est donc non seulement la distance à d’autres réalités qui est simplifiée par les technologies de l’information, mais aussi notre positionnement. Position et situation se retrouvent ainsi, ensemble, augmentant la relation spatiale des individus à leur environnement, comme prémisses d’un renouveau de la production d’informations spatiales, annonçant de nouvelles pratiques urbaines déjà émergentes. La convergence des propriétés numériques de la carte et de celles de la géolocalisation y trouve dès lors une opportunité remarquable d’adapter la carte au contexte spatial singulier de son usager.

Parmi les innovations majeures dont la carte fit l’objet ces dernières années, l’une a particulièrement transformé son potentiel : sa personnalisation. L’échelle, le contenu et le fond peuvent en effet être adaptés individuellement. Cet avantage fonctionnel repose sur l’utilisation active de la télécommunication et de l’automatisation, qui autorisent la mise à jour interactive des informations.

La personnalisation du contenu, en particulier, offre des perspectives quasi infinies. Elle permet de s’affranchir de la contrainte majeure de la carte imprimée : la prédétermination de son usage. Dans le contexte de l’impression, la réduction à l’œuvre (échelle, localisation et contenu) lors de la conception doit être suffisamment consensuelle pour mériter une impression, une distribution et un stockage. Si on ne lui impose pas d’être prédéfinie, une fois à l’écran, la carte numérique permet de se soustraire en grande partie à cette contrainte. Il est dès lors possible de valoriser virtuellement toute information dont la localisation apporte du sens. Cette interactivité suscite non seulement une quantité et une qualité7 d’information spatiale respectivement plus importante et plus diverse, mais aussi la possibilité de l’actualiser plus rapidement. Le cas limite est l’actualisation de la carte en « temps réel » (les embouteillages constituent l’exemple le plus caractéristique8, avec la localisation de radars mobiles).

Ce qui étonne, dans la démarche des projets massifs tels que Google Map, c’est l’étendue de l’espace référent qui n’est autre que le Monde dans son ensemble. Le choix de l’échelle est en cela inévitablement associé à une localisation, ce qui se traduit par une déclinaison en autant de cartes potentielles que la surface terrestre ne le permet. Dans la pratique, l’inégal traitement de la surface terrestre réduit considérablement les possibles, qui n’en demeurent pas moins d’une grande richesse.

Cette offre est le résultat d’habiles négociations de Google avec la majeure partie des fournisseurs mondiaux d’images satellites et d’information cartographique9. Elle est aussi le résultat d’arbitrages qui reposent sur une analyse de l’inégale demande spatiale d’information géographique, les espaces les plus urbanisés étant sans surprise les plus sollicités. Le choix de Google d’offrir un traitement non uniforme de l’espace qui valorise les espaces urbains ne fut pourtant pas suivi par des acteurs qui dominaient jusque là ce secteur. C’est le cas de l’offre française de l’IGN qui, avec Géoportail, proposa une couverture uniforme du territoire, moins précise dans les espaces les plus urbanisés (Fig. 1). Cette option avait toutes les chances de contrarier le plus grand nombre. Ce fut le cas, Geoportail n’ayant pas réussi à s’imposer sur son propre terrain, malgré la richesse de son offre.

Fig. 1 - Comparaison de Geoportail (gauche) et de Google Map (droite) - Paris centre - décembre 2009

En quelques années, Google a oeuvré à réduire la distance entre les individus et les cartes, en proposant une plateforme qui centralise l’ensemble des représentations tout en assurant la continuité entre ses parties

Fidèle à son objectif annoncé, Google a anticipé non seulement l’intérêt d’un large public pour la carte et l’image satellite, mais aussi l’importance du fond de carte dans un contexte de production croissante d’informations spatiales. Le fond étant la médiation dont les analogies spatiales découlent, sa maîtrise constitue un enjeu stratégique qui assure un avantage comparatif important. En cinq ans à peine. Google s’est placé au coeur des dispositifs d’informations géographiques adressées à un large public et en bonne position pour négocier avec de plus en plus de professionnels.

A ce jour, rares sont en effet les acteurs qui peuvent fournir un service de représentation et de traitement informatiques de données spatiales à l’échelle planétaire et Google en fait indiscutablement partie. Microsoft essaie activement de rattraper son retard, tandis que des acteurs plus anciens, spécialisés dans la mobilité automobile (Mappy, Michelin, MapQuest, etc.) ou la cartographie nationale (IGN), peinent à adapter leur offre à une demande de plus en plus exigeante. L’avance de Google, savamment entretenue, permet à cette société d’étendre son hégémonie par l’intermédiaire de mashups et plus généralement d’API

Cette standardisation du fond rappelle que si la personnalisation de l’échelle et dans une moindre mesure du contenu sont largement répandues, plus rares sont les services qui permettent de personnaliser le fond. Généralement, le changement du fond se limite au passage de la carte à l’image satellite

Le fait que la carte puisse être personnalisée dynamiquement est une innovation remarquable. Le traitement informatique de la carte permet une interactivité inédite, au point d’assurer non seulement la production de cartes personnalisées, mais aussi la coproduction de la carte elle-même.

OpenStreetMap, initié aussi en 2004, répond initialement au même souci que celui de Google : libérer le fond de carte de la multitude des acteurs qui se l’approprient selon des logiques souvent légitimes (dont celui de l’avoir créé), mais trop diverses et contradictoires pour être en mesure d’offrir un service adapté à un large public (cohérence, coût, etc.). En revanche, à la différence de Google, OSM

Le succès de la démarche est largement supérieur à la visibilité du projet. De 10 000 utilisateurs enregistrés en 2007, le projet est passé à plus de 190 000 fin 2009 pour plus de 1,3 milliard de track points

Ce constat, s’il souligne la forte dépendance du projet à l’égard de quelques individus et relativise les modalités pratiques de coproduction du fond, n’enlève rien à l’importance des contributions plus électives de la majeure partie des contributeurs. Par leurs connaissances fines d’un espace particulier, généralement le leur, ces derniers permettent des réajustements précieux, qui assurent la qualité de l’ensemble. Surtout, OSM propose un cadre de collaboration cohérent et ouvert, qui assure juridiquement la libre circulation des données, sous licence Creative Common By SA20. La faiblesse d’OSM tient néanmoins à son inégal traitement de l’espace mondial. Ce projet n’en demeure pas moins une ressource précieuse pour la plupart des métropoles, dont le traitement, surtout aux États-Unis et en Angleterre, est généralement de qualité.

En particulier, le format ouvert d’OSM et la « libération » du fond autorisent des projets innovants, dont le plus représentatif est probablement CloudMade21. Fondée en 2007 par Steve Coast et Nick Black, respectivement fondateur et ancien collaborateur d’OSM, cette société se donne pour objectif de simplifier la personnalisation et l’usage d’OSM dans le cadre de projets spécifiques. Il est par exemple possible de créer une sémiologie graphique adaptée à un projet (ambiance visuelle, valorisation du bâti ou des transports en commun, etc.) ou d’en sélectionner une parmi celles déjà à disposition. CloudMade propose surtout des API adaptées au développement de services de navigation automobile ou de géolocalisation. Ainsi valorisé, le potentiel d’OSM rappelle, s’il le faut, que la personnalisation du fond est étroitement associée au libre usage des analogies les plus fondamentales de la carte, celles qui associent non pas une réalité à une localisation, mais une localisation (de l’espace de référence) à une autre (de la carte).

Cette personnalisation accrue du fond offerte par des projets tels qu’OSM, ainsi que par l’ensemble de l’offre destinée actuellement à un large public, se limite néanmoins à la sémiologie graphique, ces acteurs se réservant le choix d’une composante essentielle des analogies : la projection. Cependant, la majeure partie de ces services étant utilisés à l’échelle de la ville ou du quartier, cela n’a presque pas d’incidence pratique.

La personnalisation de la carte, dans la majeure partie des cas, ne porte cependant pas sur le fond, mais sur le contenu. Non seulement il est possible d’adapter la carte à des besoins spécifiques, mais aussi de contribuer à la production de son contenu. De plus en plus répandue, cette pratique s’inscrit dans le prolongement de ce qui est communément appelé Web 2.0, à savoir le développement d’Internet comme plateforme de services qui facilitent la valorisation et la circulation de contenus produits par les internautes. Wikipédia, Flickr, YouTube, ainsi que le très ancien Craigslist22 sont symptomatiques de cette démarche.

Il n’est pas surprenant que Tim O’Reilly, à qui l’on doit la popularisation de cette expression23, se soit aussi positionné dans le débat sur le Web 2.0 spatial. O’Reilly Media est en effet l’organisateur des désormais célèbres conférences Where 2.0, dont l’objet est précisément l’étude de la production (techniques et pratiques) de données spatiales et les enjeux correspondants24. Le développement rapide de la cartographie sur Internet, depuis, est caractérisé par l’émergence d’une multitude de néologismes, ayant vocation à souligner la singularité des pratiques et des services correspondants. Géomatique 2.0 [Joliveau, 200725, 2008], GeoWeb 2.0 [Maguire, 2007], Maps 2.0 [Crampton, 2009], Géographie 2.0 [Valentin, 2007] et Web Mapping 2.0 [Haklay et coll., 2008] sont autant de propositions pour qualifier ce renouveau des pratiques et des outils cartographiques.

Dans la majeure partie des cas, le Web 2.0 spatial se caractérise par la coproduction de contenus géolocalisés (un track point étant son expression la plus élémentaire). Ces pratiques vont de la coproduction du fond de carte (OSM) à la localisation d’une photo (Flickr), de toilettes publiques (Où sont les toilettes ?26), d’un restaurant (Yelp, Foursquare27, Qype, etc.) ou d’un nid de poule (FixMyStreet28). Souvent, cette démarche s’accompagne de la possibilité de qualifier ces espaces (commentaires, évaluations, tags, etc.). Dans ces conditions, la carte est réduite à sa plus simple fonction : la localisation. Cette tendance ne fait que renforcer la place de ceux qui maîtrisent les analogies élémentaires (coordonnées géographiques). Ce sont finalement de considérables bases de données géoréférencées qui se constituent chaque jour un peu plus, dispersées parmi les nombreuses initiatives qui proposent ce type de services.

Ce renouveau de la production d’information spatiale, en sus du Web 2.0, participe ainsi d’un renouveau plus général de la qualification et de l’évaluation, qui repose sur un présupposé implicite : les individus concernés par un sujet particulier (encyclopédie, cartographie, tourisme, cinéma, etc.) en sont aussi les meilleurs évaluateurs et les meilleurs experts, pour peu qu’il soit possible de mettre en commun une multitude d’expériences et de compétences singulières. Cette hypothèse, toujours provocante malgré la prolifération d’exemples en sa faveur, ne pouvait pas être éprouvée sans les technologies de la distance actuelles. Internet fut en cela l’occasion d’expérimenter à grande échelle un projet humaniste qui n’attendait que les moyens de s’exprimer.

C’est pour le moins ce que le philosophe Pierre Lévy proposa en 1995, en annonçant l’avènement de l’intelligence collective. « Personne ne sait tout, tout le monde sait quelque chose, tout le savoir est dans l’humanité. Il n’est nul réservoir de connaissance transcendant et le savoir n’est autre que ce que savent les gens » [P. Lévy, 1995, p. 29]. Le glissement du Web 2.0 à l’intelligence collective participe en cela d’une problématique commune (les moyens d’une part, les résultats de l’autre). Cet héritage de l’ouvrage de Pierre Lévy fut reconnu sans le citer par Tim O’Reilly et John Battelle lors du Web 2.0 Summit d’octobre 2009, lorsqu’ils proposèrent de parler de Web Squared29.

Le Web Squared y est présenté comme le prolongement du Web 2.0, d’où émergerait de l’intelligence collective par accumulation de faits en apparence non structurés. Pour cela, ils opposent le sens implicite au sens explicite, soulignant que l’intelligence peut émerger de la déduction de faits indépendants du sens que l’on peut leur donner a priori. C’est, en d’autres termes, la masse des données qui permet de faire émerger du sens. Aux désormais classiques exemples d’Amazon (l’achat est une évaluation), Digg (la recommandation est une évaluation), Google (un lien hypertexte est une évaluation), ils ajoutent un exemple spatial plus singulier, qui définit l’étendue d’un territoire à partir des coordonnées de photos géotaggées : The Shape of Alpha30. Le résultat, s’il ne coïncide pas avec le contour administratif de l’espace considéré, n’en demeure pas moins représentatif de l’analogie entre ce territoire et ses représentations (à l’erreur près des GPS et toutes proportions gardées quant à la représentativité des individus qui proposent des photos géoréférencées sur Flickr).

Cette dynamique questionne non seulement la production d’informations géographiques, mais aussi une certaine forme de connaissances géographiques plus ou moins fondamentales. Du fond de carte à la qualification ou à la description d’espaces, une quantité considérable de connaissances spatiales individuelles convergent au sein de ces multiples plateformes.

Cette irruption massive de la production amateur d’information géographique est à présent qualifiée de neogeography, une géographie complémentaire de la géographie professionnelle, qui la questionnerait dans ses fondements par la diversité des pratiques et des représentations qui la caractérisent et la qualité qui en émerge parfois. Ce terme reste néanmoins peu lisible, tant il est empêtré dans une polysémie instable et des projets dont les ambitions semblent largement dépasser ce dont il est question.

Bien que ce terme fut utilisé vainement à plusieurs reprises, ce n’est qu’en 2006 que le sens actuel s’est à peu près stabilisé. Il fut initié par Randall Szott31 conjointement à Di-Ann Eisnor32, qui l’utilisa comme mot-clé dans le blog associé à Platial.com33, dont il est le cofondateur. Di-Ann Eisor précise qu’il n’est pas tant question de « nouvelle » géographie, mais de géographie « à la manière de ». La neogeography recouvre alors toutes les pratiques cartographiques non professionnelles aussi « intuitives, expressives, personnelles, absurdes, et/ou artistiques » soient-elles (ibid.). Elle permet d’intégrer une multitude de productions spatiales, essentiellement cartographiques, à un champ identifié et susceptible d’en valoriser la pertinence et l’existence.

Un deuxième sens, un peu plus restreint, s’inscrit dans le prolongement spatial du Web 2.0 et des innovations techniques correspondantes. Il est sans grande surprise porté par O’Reilly Media et les conférences Where 2.0. [Turner, 2006, 2008]. Il est alors question du renouveau des outils et des pratiques de production d’informations géographiques amateur. La dimension technique de l’innovation y est nettement plus présente.

La distinction entre l’innovation technique d’une part et l’innovation sociale d’autre part reste très présente dans les débats autour de ces problématiques. Le risque, souvent, est de surestimer l’autocapacité de ces dispositifs à créer du sens et, par continuité, de confondre la cartographie et la géographie. Ce constat explique probablement pourquoi le terme neogeography reste académiquement essentiellement associé à la géographie des technologies de l’information et plus encore à la géomatique. L’idée selon laquelle la géographie œuvre à la localisation et à la qualification de réalités spatiales est certes toujours répandue, mais elle n’a que très peu à voir avec la géographie contemporaine. Elle renvoie à une géographie idiosyncratique dont la fonction fut de décrire la surface terrestre, de délimiter des territoires et de caractériser l’inégale répartition des ressources. La géographie contemporaine a un projet autrement plus délicat : étudier la dimension spatiale du social. Largement engagé depuis les années soixante, ce renouveau de la discipline consiste à prendre l’espace au sérieux34 et, précisément, à lui donner du sens.

Au-delà du Web Squared et de la neogeography, l’idée selon laquelle le sens émergerait spontanément de l’accumulation massive de données connaît actuellement un intérêt significatif, impulsé en partie par le texte provocant de Chris Anderson : «The End of Theory: The Data Deluge Makes the Scientific Method Obsolete»35. Le rédacteur en chef de la revue Wired y présente l’avènement d’un nouveau paradigme, selon lequel la théorie ne serait plus nécessaire, dès lors que les données seraient devenues suffisamment nombreuses pour s’en dispenser. « With enough data, the numbers speak for themselves. [...] Correlation supersedes causation, and science can advance even without coherent models, unified theories, or really any mechanistic explanation at all ».

Physicien de formation, Chris Anderson n’explique cependant pas comment le sens émergerait spontanément des données et ce que l’on pourrait bien faire de corrélations qui ne s’articulent pas à une théorie. L’idée selon laquelle les faits parlent d’eux-mêmes, si elle n’est pas rare, néglige une des avancées majeures des sciences du XXe siècle : le sens est une construction, qui s’appuie certes sur l’expérience, mais qui ne s’y résume pas. Penser les données et les corrélations comme les fondements de la science et non comme des moyens revient à omettre ce que la science a de plus fondamental : chercher des relations entre des phénomènes et leur donner du sens. Cela suppose d’être vigilant en amont et en aval du processus scientifique, lors de la production d’indicateurs (de quoi les données rendent-elle compte ?) et de la production de sens, qui n’ont pas vocation à décrire, mais à comprendre des phénomènes. C’est bien la nuance entre la description et la compréhension qui est malmenée par de tels projets !

Le Web Squared ou la neogeography n’en demeurent pas moins symptomatiques d’un renouveau considérable de la capacité d’Internet à rendre le monde plus intelligible. Plus que la fin des théories ou l’émergence d’une géographie amateur, c’est surtout le statut de l’empirie qui est reconsidéré par l’abondance des données. Le fait que chaque individu, par ses pratiques, apporte de nombreuses informations (lien hypertexte, vote sur Digg, achat sur Amazon, statut sur Facebook, recherches sur Google, évaluation d’un restaurant, etc.) est une occasion inespérée, non pas de renoncer à la théorie, mais au contraire de la confronter, de l’inspirer et de la développer en relation avec des données plus diverses et complémentaires des méthodes préexistantes.

Supposer que les résultats de Google, les suggestions d’Amazon ou la qualité de Wikipédia ne doivent qu’à l’accumulation massive de contributions individuelles reviendrait à négliger la complexité de leurs fonctionnements, qui exigent de nombreux réajustements et un projet qui structure l’information. Une telle position nierait aussi les démarches innovantes de leurs concepteurs et administrateurs, qui contribuent précisément à donner du sens à des données qui n’en auraient pas a priori. Aussi, Wikipédia ou OSM, par exemple, doit faire preuve de nombreuses autres innovations, sociales, nécessaires à la mise en commun des compétences individuelles et au maintien de la qualité de l’ensemble (en particulier les critères d’attribution de droits, les règles d’usage et l’importance des traces) [Auray et coll., 2009].

L’enjeu de la géographie, des sciences sociales, mais aussi de tous les individus qui s’intéressent aux faits sociaux est à présent de prendre la mesure de l’ensemble de ces connaissances et de les mobiliser pour mieux comprendre les dynamiques contemporaines. Il s’agit de continuer non seulement à décrire notre environnement, mais aussi à mieux le comprendre. C’est cela la différence essentielle entre les données et ce que l’on en fait, entre les faits et leurs effets. Le Gross National Happiness index36 de Facebook ou le Flu Trends37 de Google ne sont qu’une étape qui ne doit pas faire oublier que le passage des statuts de Facebook à cet index ou des requêtes dans Google à l’évaluation régionale de la grippe exigea la mise en place d’indicateurs et de modèles, sans quoi ils n’auraient pas de sens. C’est aussi la conclusion heureusement ambivalente de ce même article de Chris Anderson : « There's no reason to cling to our old ways. It's time to ask: What can science learn from Google ? ».

Le renouvellement de la carte participe ainsi d’un renouveau de la relation à l’espace. L’augmentation considérable des données spatiales est aussi celle des analogies, augmentant la carte d’autant d’informations contextuelles. Des informations qui, de par leur association à un espace singulier, sont en mesure de nous informer sur cet espace. Les contextes au sein desquels ces informations sont produites, stockées, analysées ou divulguées soulèvent de nombreux enjeux dont il est encore difficile de prendre pleinement la mesure. Elles offrent d’importantes perspectives, à même d’augmenter le potentiel de la ville et de la rendre plus lisible. Il convient néanmoins de prêter une attention particulière aux modalités pratiques de ce renouveau et aux illusions dont il est porteur. Ce que ces nouvelles analogies donnent à voir de la ville a précisément un sens qui ne s’impose pas !

Aussi, la ville est transformée de cette visibilité accrue. En sollicitant de plus en plus des cartes numériques, par transduction38 [Dodge et coll., 2005], il semble que la ville passe progressivement de background coded space à Code/Space39, à savoir d’un espace dont la technologie n’est qu’accessoire à un espace dont elle est une composante indispensable, par l’intermédiaire des pratiques urbaines. C’est en tout cas ce dont nous prévient Adam Greenfield, sans considérer spécifiquement la carte, lorsqu’il insiste sur la propension des technologies à devenir ubiquitaires et à se confondre peu à peu avec notre environnement (Everyware) [Greenfield, 2006]. En 2008, il déclina ce raisonnement dans une perspective urbaine synthétique, lorsqu’il suggéra que les technologies de l’information apportaient à la ville une considérable profondeur historique (The long here) et une quantité remarquable d’informations locales instantanées (The big now).

C’est dans le contexte de cette articulation intense avec les réseaux de l’information que la ville se transforme peu à peu, si ce n’est morphologiquement pour l’instant, tout au moins dans ses représentations et peu à peu dans les pratiques qui la façonnent. C’est non seulement son potentiel d’interaction qui s’en trouve accru, mais aussi sa lisibilité. Il est en cela indispensable de considérer, ensemble, tant le déploiement de ces technologies que ce dont les cartes coproduites et automatiques rendent compte. Assurément, ce n’est pas parce qu’elles n’ont plus d’auteurs qu’elles ne mentent pas [Monmonier, 1991] et qu’elles ne deviennent pas de plus en plus intrusives, tant elles exposent le singulier au regard de tous.

L’enjeu le plus important, probablement, tient en la capacité des cartes dynamiques à augmenter le potentiel de la ville. En privilégiant la densité et la diversité, la ville se caractérise par une distance interne et une opacité importante. Les virtualités de la ville, pour une large part, ne sont pas réalisées parce que méconnues ou trop contraignantes. Aussi, attribut caractéristique de la ville, l'anonymat se traduit souvent par la méconnaissance de l’entourage. Les affinités électives s’y déploient selon d’autres logiques (professionnelles, amicales, familiales, etc.) qui s’affranchissent des relations de proximités topographiques. La ville autorise en effet une vie sociale riche sans nécessairement connaître son voisinage. C’est cette propriété qui vaut à son « air », depuis le Moyen-âge, d’avoir la réputation de rendre libre : libre de choisir ses affinités ; libre de déployer ses pratiques dans l’anonymat ; libre de ne pas avoir à rendre de compte.

Il n’en demeure pas moins que les distances internes sont importantes et que notre environnement peut être riche d’expériences potentielles dont nous n’avons pas connaissance. La carte, et par continuité la multitude de services qui valorisent l’information spatiale, ont précisément vocation à rendre la ville plus lisible. Google Map, en premier lieu, est de ceux qui proposent le fond de carte, ainsi que des informations de plus en plus nombreuses (stations de métro, restaurants, magasins, photos, vidéos, etc.). C’est un domaine pour lequel la coproduction de l’information spatiale par les habitants eux-mêmes est une occasion remarquable d’augmenter la qualité des représentations et leur adéquation avec les pratiques.

En valorisant le crowdsourcing40, il n’est alors pas question, pour quelques-uns, de préjuger de ce qui intéresse le plus grand nombre, mais au plus grand nombre, par l’expression de ses intérêts, d’en produire une représentation plus « représentative », diverse et singulière en ses parties. Jamais il ne fut à ce point possible de prendre la mesure du potentiel de l’urbanité et, pour peu que l’on en ait l’envie, le courage peut-être, de l’actualiser. Ce potentiel, de surcroît, se voit amplifié par des pratiques qui participent elles-mêmes de l’innovation et du renouvellement des potentialités et des intentionnalités à venir. Les technologies de l’information, en virtualisant la carte, rendent la ville moins virtuelle. Elles permettent de réconcilier les affinités et les proximités, renouvelant remarquablement la notion même de voisinage41.

Cette visibilité accrue suggère l’altération d’une propriété essentielle de la ville : la sérendipité. La capacité de la ville à produire des rencontres et des découvertes inattendues et vertueuses peut sembler être largement affectée par de tels dispositifs. Cette lecture de la sérendipité et plus encore des technologies spatiales de la visibilité de l’urbain est pourtant en partie erronée. S’il est en effet plus difficile de se perdre, rarement des individus peu à l’aise avec l’espace se sont laissés à ce point libres de s’égarer, se livrant à des pratiques et à des découvertes qui n’auraient pas eu lieu sans ce « filet ». Cet effet libérateur de ce qui apparaît à première vue aliénant n’est pas sans rapport avec les centres de vacances qui, tout en limitant le contact avec l’altérité locale, en sont par ailleurs de puissantes entrées, initiant des individus qui, sans ce point d’appui, ne se seraient jamais confrontés à des espaces aussi peu familiers [Équipe Mit, 2002].

Surtout, il importe de reconsidérer la sérendipité dans ce contexte particulier, en ne la limitant pas à la découverte au moment de son expérience, mais au regard de ce qui l’a initiée. La carte, enrichie d’une multitude d’expériences individuelles, ajoute à la ville des signes, plus ou moins signifiants, qui engagent ou non à les suivre. Tels un panneau, un bruit, une lumière, une vitrine ou des traces de pas, ces informations ajoutent à ce qui encourage à ne pas faire ce qui était prévu. La sérendipité n’en est que plus présente pour ceux qui ne se laissent pas guider par les automatismes, s’accordant la liberté de choisir parmi les possibles.

La carte, par l’ensemble des analogies qu’elle donne à voir, permet de situer des réalités dont une grande part est invisible ou ne peut pas être appréhendée du regard. Les cartes sont en effet un puissant formalisme de la dimension spatiale de notre environnement. En situant les réalités les unes par rapport aux autres, elles proposent un agencement qui rend lisible une spatialité particulière. Les cartes électorales, par exemple, sont un exemple de représentation spatiale d’un fait social qui n’est pas visible autrement. Pour autant, les cartes n’en sont pas moins révélatrices de structures spatiales fortes. Les votes démocrate et républicain aux États-Unis lors des élections de 2004 et 2008, le vote français au traité constitutionnel européen de 2005 ou la votation suisse sur l’interdiction de construire des minarets, toutes ces occasions de s’exprimer depuis un espace particulier se traduisent effectivement par une structure spatiale comparable : une nette opposition entre les espaces les plus urbanisés et leurs périphéries42 [Andrieu et coll., 2007].

Les technologies de l’information sont en cela une opportunité inédite de rendre la ville plus lisible. Les informations coproduites par ceux-là mêmes qui habitent et pratiquent l’espace sont autant de sources précieuses complémentaires, donnant à voir des pratiques et des représentations spatiales jusqu’à présent difficiles d’accès. Directement ou indirectement, ces informations sont autant de traces qui informent de parcours, de polarités, et de représentations qui leur sont associées. Considérées avec précautions, elles permettent l’économie d’enquêtes coûteuses et fastidieuses, mais aussi celle de biais inhérents à l’intervention du chercheur dans le processus de formalisation des représentations.

Autoproduites par ceux qu’elles représentent, ces données n’ont cependant pas tout à fait le même statut. Au même titre que les journaux extimes, elles donnent à voir ce que les individus disent d’eux-mêmes (ce que je ressens, ce que j’en dis, ce que j’en montre), mais aussi ce qu’ils font, les traces étant de plus en plus nombreuses (cookies, comptes, photos géoréférencées, cellules téléphoniques, achats, etc.). L’exposition de soi dans un contexte particulier, dont les réseaux sociaux, n’exclut pas la mise en scène. Ce n’est donc pas d’une représentation fidèle dont il s’agit, mais d’une représentation qui ne s’adresse pas au chercheur en particulier43.

Ces dernières années, quelques projets et études ont révélé le potentiel de ce type de données, faisant l’objet de travaux plus ou moins sérieux. De simples communications visuelles (Palantir44, Facebook Global New Friends Connexion45, etc.) à des travaux très approfondis, en passant par des expérimentations originales ou stimulantes (Real Time Rome46, sa « copie » plus récente UrbanMobs47, New York Talk Exchange48 et Just Landed49), nombreuses sont les perspectives de valorisation de données spatiales disséminées au sein des grandes plateformes de données (opérateurs de téléphonies, Facebook, Twitter, Flickr, etc.).

Quelques individus, aussi, se distingue par la qualité de leurs recherches. À ce jour, les travaux de Fabien Giradin comptent parmi les plus aboutis, soulignant une large palette de problématiques (sources, usages, respect de la vie privée, enjeux, etc.). Sa thèse, soutenue en 2009, rassemble divers articles qu’il a publiés sur le sujet [Giradin, 2009], en particulier son utilisation de Flickr pour visualiser les parcours de touristes et les distinguer de ceux des résidents [Girardin et coll., 2008]. Elle apporte des compléments innovants aux méthodes préexistantes et participe efficacement de ces démarches qui rendent la ville plus lisible. Le senseable city lab50 du MIT, avec lequel Fabien Giradin a collaboré, est aussi un des laboratoires de recherche qui explorent le plus activement cette problématique, déclinant quelques projets innovants sur cette thématique, dont WikiCity51, prolongement de RealTime Rome.

Néanmoins, à l’exception de quelques travaux, rares sont les projets qui ont fait l’objet d’un approfondissement au-delà de l’exercice de style. Les problématiques sont souvent faibles ou inexistantes et la majeure partie de ces initiatives viennent essentiellement d’informaticiens ou de designers qui se satisfont (assez légitimement) de l’effet visuel, parfois intense, de la représentation spatiale de ces données. Cela engage les urbanistes, sociologues, géographes et autres personnes sensibles aux représentations de la ville, pour répondre à la provocation de Chris Anderson52, à investir activement ce potentiel, afin de participer à ce renouveau important des moyens dont nous disposons pour appréhender les villes invisibles53. La sociologie urbaine contemporaine, en particulier, est parfaitement consciente de l’opacité de la composante la plus essentielle de la ville : ses représentations. La morphologie urbaine, les pratiques sociales et les représentations, si elles s’influencent réciproquement, sont en effet respectivement d’autant moins visibles que leur influence est importante [Bassand et coll., 2001].

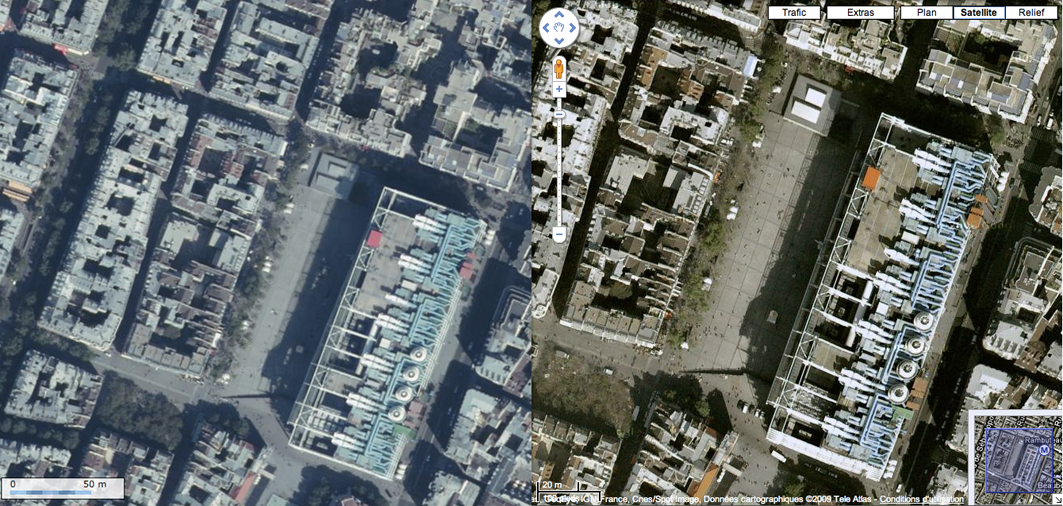

Fig. 2 - Metropolitan Police Crime Mapping - décembre 2009

Rendre visible l’invisible relève d’un processus de représentation qui suppose une construction de l’espace représenté. La cartographie, de ce point de vue, ne fait aucunement exception, tant elle exige d’arbitrages qui mériteraient d’être mieux explicités. Que représente-t-on ? Quelle relation existe entre ce qui est représenté et ce qui représente ? Qu’est-ce qui est omis ? Pourquoi utiliser telles couleurs et non telles autres ? Pourquoi cette discrétisation statistique ? Pourquoi cette échelle ? Pourquoi cette projection ? Nombreuses sont les questions qui, chacune, rappelle le réductionnisme nécessaire à la mise en carte d’un espace.

Pourtant, la carte jouit d’un « effet de réel » propice à l’illusion, selon lequel la carte est ce qu’elle figure. Par la puissance formelle de ses analogies, la carte se confond avec ce dont elle rend compte, au point d’être un remarquable vecteur des représentations spatiales. Cette force figurative est telle qu’elle finit par être le référent d’autres phénomènes, à l’image de la représentation que l’on a de son propre pays, que l’on n’a pourtant jamais vue d’un seul tenant. C’est en effet essentiellement à la carte que l’on doit la cohérence de notre représentation du territoire national et plus encore du Monde.

De ce point de vue, René Magritte nous a bien préparés à ne pas confondre une image et ce qu’elle représente [Magritte, 1929]. « Ceci n’est pas une pipe », ajouté à la toile pour nous rappeler à l’illusion dont nous sommes volontiers les complices, résume parfaitement la trahison des images. La carte est tout aussi insidieuse. Non seulement elle n’est pas l’espace qu’elle représente, mais elle est aussi l’objet de représentations abstraites, opérant une double illusion : celle de l’analogie entre l’espace représenté et la carte qui le représente, mais aussi entre ce qui est représenté et sa représentation. Par exemple, une carte du crime à Londres figure Londres, mais aussi la criminalité. Si cette carte n’est pas Londres, la représentation de la criminalité est moins encore la criminalité, dont l’indicateur statistique fait l’objet d’une réduction telle qu’il n’a parfois que peu à voir avec ce dont il prétend rendre compte. Le Metropolitan Police Crime Mapping54, par exemple, laisse supposer une criminalité élevée et concentrée dans le centre de Londres (fig. 2). Pourtant, cette représentation doit essentiellement à une succession de biais statistiques, la criminalité effective rapportée aux nombres de réalités potentiellement impliquées (individus, commerces, véhicules, etc.) y étant au contraire relativement faible [Beaude, 2009].

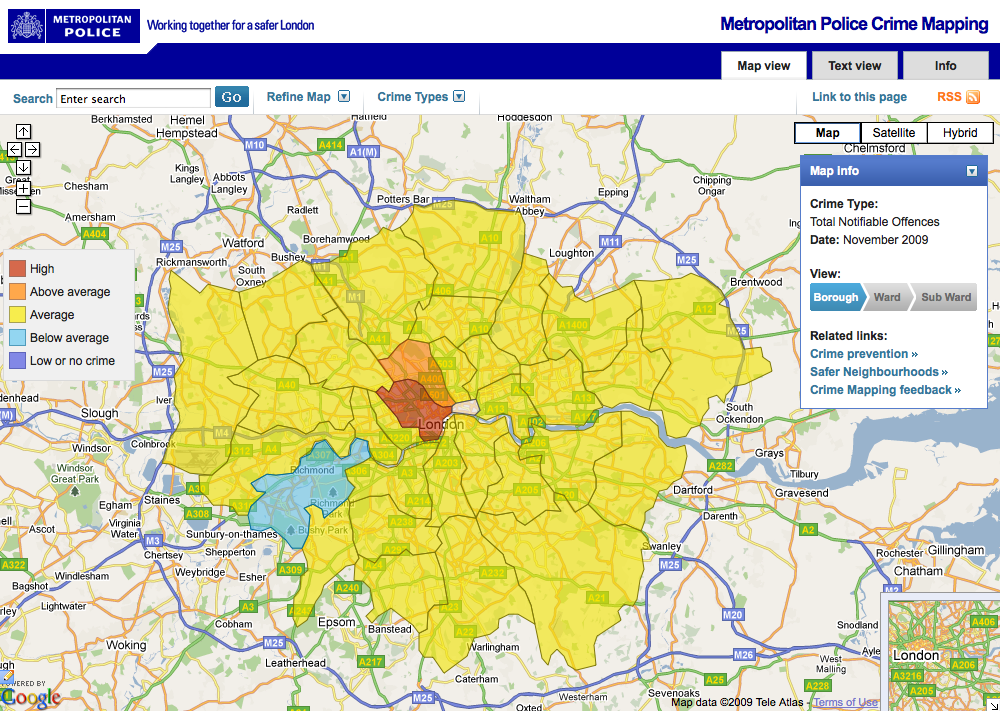

Aussi, la neogeography n’est qu’une des évolutions de la carte. Beaucoup de projets innovants ne reposent pas sur la production de contenu par des non professionnels. L’association anglaise à but non lucratif mySociety55, par exemple, développe actuellement une carte interactive, Mapumental56, qui s’actualise dynamiquement selon des critères jugés déterminants pour la localisation d’un logement (fig. 3). Les critères retenus dans la version expérimentale sont le temps de trajet pour arriver à 9h00 dans la zone de référence, le coût du foncier et le caractère « pittoresque » (scenicness) de l’espace. Pour réaliser cette carte, furent utilisées : OpenStreetMap pour le fond, la base de données Traveline57 du National Public Transport Data Repository pour les temps de transport (version d’octobre 2008), le Land Registry for England and Wales58 pour les prix du foncier (entre janvier 2008 et mars 2009) et ScenicOrNot59 pour le caractère « pittoresque ».

Cette dernière source, la plus subjective, est un site qui a été développé spécifiquement pour Mapumental par l’association mySociety. Il repose sur l’évaluation collective du caractère pittoresque de photographies

Si l’on prête un peu attention à la construction de cette carte, on peut observer que l’exercice n’est pas simple. Le caractère pittoresque d’une image n’étant pas défini et son acception pouvant différer considérablement d’un individu à un autre, il n’est surprenant de constater que la note moyenne des photos, de 4.56 sur 10, n’est pas représentative. Le coefficient de variation moyen de l’évaluation de chaque image est de 0.371, alors qu’il est de 0.372 entre les images. Cela signifie qu’il y a une variation comparable entre les notes pour une même image et les moyennes de chaque image.

Fig. 3 - Mapumental - MySociety.org - décembre 2009

Ce constat est un exemple remarquable du risque de l’approche consensuelle du goût, le résultat pouvant produire une image qui n’a pas de sens, puisqu’elle attribue des valeurs locales dont l’hétérogénéité interne est comparable à l’hétérogénéité externe. Si l’on ajoute à cette approximation celle du choix arbitraire d’une photographie qui représente 1 km2, l’inégale évaluation de chaque image (de 3 à 162 votes pour une moyenne de 5.39) et les limites des autres indicateurs, tel que le temps de transport qui ne prend pas en compte l’automobile, il apparaît nettement que la lecture de telles images exige une grande prudence, bien que nous soyons tentés de nous abandonner à la force synthétique de leur représentation.

Nombreux sont les exemples qui engagent à être prudent, l’automatisation de la représentation, à l’image du Metropolitan Police Crime Mapping de Londres ou de Mapumental, n’étant absolument pas un gage de conformité entre ce qui est représenté et sa représentation. Les images ainsi produites n’en demeurent pas moins très représentatives des représentations spatiales, puisqu’elles en sont un des puissants initiateurs.

Mapumental est néanmoins une initiative d’autant plus intéressante et exemplaire, qu’elle livre explicitement une grande part de ses faiblesses

Fig. 4 - Agora Carte - décembre 2009

La neogeography, de ce point de vue, n’a pas le monopole de l’inadéquation de la carte avec ce dont elle prétend rendre compte. Les pratiques amateures ou artistiques se distinguent surtout par la démarche adoptée, qui ne prétend précisément pas rendre compte de ce qui est, mais d’un point de vue particulier. À l’illusion de la carte, s’ajoute alors une difficulté supplémentaire : comment une somme d’expériences individuelles peut-elle rendre compte de l’expérience collective ? Quelles cartes émergent des singularités ?

La coproduction de l’information spatiale peut dès lors être appréhendée selon différentes perspectives, qui ne se résument pas à l’amateurisme de la démarche. On peut y voir une source d’informations complémentaires, dont il importe de définir le statut particulier. Plus que la représentation, l’enjeu est probablement celui du renouveau de l’intermédiation, de l’accès à des informations qui ne sont généralement pas exprimées. La neogeography est en cela une opportunité de rendre visible des expériences et des impressions qui ne sont pas recensées par d’autres méthodes, ou trop inefficacement pour être exploitables. Elle est à la fois le mode de représentation et le mode de collecte des données. Un contexte de production qui rend l’expression singulière suffisamment simple pour rendre compte de faits qui n’engageraient pas de procédures susceptibles de les partager.

Reste, à présent, à articuler pleinement ce potentiel avec des projets qui ne se limitent pas à la simple expression des expériences individuelles. Trop d’initiatives, faute de se limiter à la mise en place des outils nécessaires à la coproduction de la représentation, finissent par produire des images illisibles ou incapables d’être traitées convenablement. Il n’est pas question des cartes individuelles (MyMaps de Google par exemple), mais des projets qui proposent aux habitants de coproduire les représentations de leurs espaces.

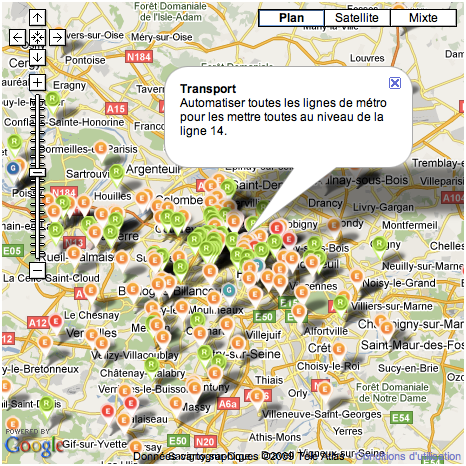

C’est le cas d’un grand nombre de cartes participatives construites sur les API de Google, qui se résument à un amas de contributions qui se superposent jusqu’à produire une image impressionniste, dont on ne retient souvent qu’une vague impression. L’exemple de « l’Agora Carte »

Nous ne sommes alors pas à l’abri de revendications dont la référence spatiale figurée sur la carte n’est autre que celle de leur expression. Par exemple, un picto associé à la station de métro Pont Neuf, dans le 1er arrondissement de Paris, est porteur de la revendication suivante : « Transport - Automatiser toutes les lignes de métro pour les mettre toutes au niveau de la ligne 14 ». Il n’en demeure pas moins que cette information est intéressante dans le cadre d’une campagne et que cette initiative participe d’une tendance plus générale, à l’image de Points-noirs

Ces projets, selon différentes perspectives, rappellent qu’ils sont indissociables du contexte qui les a initiés, ce dernier étant rarement de produire des représentations lisibles de l’environnement urbain, mais essentiellement de localiser des revendications individuelles ou, plus simplement, de créer un espace de dialogue sans qu’il soit nécessairement possible d’en assumer les conséquences. C’est en particulier le cas de Camden DCCB IIM qui, conformément à de nombreux projets similaires, finit par avoir l’effet inverse de celui escompté : nuire à l’image de la ville, dès lors qu’il apparaît explicitement que la majeure partie des déclarations n’est pas traitée par l’administration locale.

L’expérience individuelle, dans la majeure partie de ces expériences, ne produit donc pas vraiment de représentation collective, si ce n’est par la masse des expressions localisées. L’ensemble, lui, reste illisible, car il ne fait pas l’objet d’un traitement spécifique. C’est, s’il en faut, un exemple de l’incapacité des faits à parler d’eux-mêmes. Pour faire émerger du sens, il faut un modèle, aussi simple soit-il, qui permette de passer d’un fait à une signification.

Il existe néanmoins un type intermédiaire de cartes participatives, qui produit une forme de représentation de l’expérience collective, comme synthèse d’expressions individuelles : les cartes d’évaluation d’espaces publics

Très nombreux, ces projets se disputent la très convoitée évaluation collective des espaces locaux. Yelp, Dismoioù, Cityvox ou Qype comptent parmi les plus représentatifs, qui souhaitent devenir les nouveaux guides urbains, dont la qualité reposerait sur leurs propres clients, devenus utilisateurs et producteurs du contenu, conformément aux pratiques du Web 2.0. Ces projets, dans leur ensemble, se résument néanmoins à d’importantes bases de données géolocalisées, qui peinent à proposer une lecture synthétique de la ville (évaluation qualitative de rue ou de quartier par exemple70). Aussi, la démarche questionne tant elle fonctionne par agrégation, rendant illisible les singularités et « modes de vie » plus singuliers, les lieux les plus valorisés étant finalement ceux qui font le plus consensus. Cette production de représentations consensuelles de la ville apporte une grande visibilité à des lieux de qualité parfois peu connus, mais elle ne permet pas de distinguer des espaces typés, qui peuvent répondre parfaitement à certains individus sans pour autant faire l’unanimité. L’écart type, par exemple, n’est pas exploité explicitement par ce type de plateforme. Identifier des sous-profils pertinents exigerait beaucoup de données et des grilles de lectures plus fines.

CitySense71, un projet développé en collaboration avec Yelp par la société Sense Network72, œuvre précisément à dépasser cette limite en identifiant des ensembles de lieux présentant des similitudes, parce que fréquentés par les mêmes individus. Ce type d’initiative, qui associe de nombreuses données (Taxis, opérateurs de téléphonie, Yelp, mais aussi leur propre application) laisse entrevoir le potentiel de ces plateformes, pour peu que ceux qui les animent ne se contentent pas d’agréger simplement des expériences individuelles. Sense Network développe pour cela un service, appelé MacroSense, qui a vocation à ne pas limiter cette démarche aux lieux festifs, principale cible de CitySense73.

Cet enjeu est d’autant plus important, qu’il s’inscrit dans une problématique fondamentale, qui n’a pas attendu le renouveau de la cartographie pour s’exprimer. In fine, ces projets ont vocation à rendre la ville plus lisible, en s’appuyant sur l’expérience d’autres individus. Il est alors question de la délégation du jugement, rappelant la propension au mimétisme caractéristique de la nature humaine, dont les pratiques se déploient largement par reproduction de pratiques préexistantes74. Les lumières, qui caractérisent ce moment d’où l’humanité est sortie grandie de la capacité des individus à « se servir de leur entendement sans la direction d’un autre » [Kant, 1784, §1], sont à présent confrontées à la délégation de l’entendement non pas à une autorité suprême ou transcendantale, mais à « l'immanence » du consensus des expériences individuelles. Doit-on y voir l’issue dramatique d’une parenthèse de clairvoyance ou, au contraire, le prolongement d’un mouvement humaniste qui y trouverait l’expression même de son affranchissement ? C’est ce que laisserait supposer Gabriel Tarde, dès la fin du XIXe siècle, lorsqu’il montra que l’imitation, loin de nuire à l’individualité, est au contraire une des prémisses de l’innovation sociale. Parce que l’imitation n’est jamais vraiment semblable, elle serait un puissant moteur de l’évolution, chacun œuvrant à imiter au mieux de sa convenance les pratiques existantes. « Les répétitions sont donc pour les variations » résume-t-il [Tarde, 1890, p. 7].

La convergence des technologies de l’information et de la carte, dès lors qu’elle implique de plus en plus d’individus, questionne aussi la circulation de l’information et le respect de la vie privée. Les représentations de l’espace, dès lors qu’elles puisent dans des ressources de plus en plus nombreuses, questionnent la trace que laissent les individus et ce qui en est fait. En cela, non seulement l’usage de ces nouvelles représentations suppose de savoir se soustraire au risque du lissage insignifiant des indicateurs consensuels, mais aussi, paradoxalement, à l’exposition inégalée des données désagrégées et parfois individualisées.

Ce paradoxe entre la liberté des lumières et l’endoctrinement de la modernité n’est pas sans rappeler l’avertissement de Michel Foucault, lorsqu’il décrit les sciences de l’homme comme instruments du pouvoir disciplinaire et l’hétérotopie comme la spatialité correspondante (prisons, écoles, casernes, hôpitaux, etc.) [Foucault, 1975]. L’encadrement de l’action, en passant de l’exposition de la peine à l’isolement des individus, s’est traduit plus récemment par un contrôle préventif accru, qui n’a pas vocation à surveiller le prisonnier, mais tout individu susceptible de le devenir. Quinze ans après Surveiller et punir, Gilles Deleuze précisa d’ailleurs que l’hétérotopie n’était plus en marge. Elle est à présent partout : le contrôle est spatialement distribué [Deleuze, 1990]. Le passage de la prison au bracelet électronique n’est qu’un symptôme de cette transition plus générale de la société disciplinaire à la société de contrôle. Internet, dont le développement auprès d’un large public est postérieur aux propos de Gilles Deleuze, ne fait que renforcer cette logique selon une intensité inédite. Cette perspective particulière questionne sous un autre jour la lecture de William Mitchell du rhizome, lorsqu’en 1999 il le décrit en ces mots : « Deleuzian terminology is useful here we might say that the global urban system is becoming less hierarchical and more rhyzomic in character » [Mitchell, 1995].

Cette hypothèse de la surveillance décentralisée et déléguée à l’ensemble des individus est au cœur du renouveau de la cartographie qui, par la mise en ligne de réclamations ou d’évaluations individuelles, revient à placer chaque individu au coeur d’un vaste système de contrôle de l’espace. Une voiture abandonnée, un voisin suspect, un voisin ayant été condamné pour crime sexuel, un cheveu dans un plat, des draps pas lavés, des toilettes pas propres, tout peut être virtuellement indexé, géoréférencé et donné à voir à la face de monde.

Cette logique de panoptique inversé annonce une société dont il est difficile de prendre actuellement la mesure. Cette transparence accrue des pratiques et la difficulté à lui donner du sens exigent de prendre au sérieux les plateformes qui en assurent la circulation et la centralisation. La surveillance, n’étant plus surplombante, mais potentiellement en chaque individu, devient en quelque sorte ce que Jean-Gabriel Ganascia a récemment appelé la sousveillance [Ganascia, 2009]. Le panopticon est devenu un catopticon75, un dispositif par lequel chacun est en mesure de voir chaque autre. C’est un large défi qui est posé à la société des individus [Elias, 1987]. L’urgence du développement d’une improbable éthique universelle s’est rarement imposée avec une telle évidence, dès lors que les plateformes, elles, tendent à se mondialiser et impliquer les individus dans un même monde, le Monde.

Globalement, c’est le contexte au sein duquel se déploie la carte qui doit être questionné. La concentration des analogies élémentaires (fond de carte) entre quelques acteurs pose autant de problèmes que la dispersion des données produites par les individus parmi une quantité considérable de services, qui n’assurent que très exceptionnellement une politique explicite et pérenne de respect des données ainsi coproduites. Aussi, ainsi dispersées, les services peinent à disposer d’un effet de réseau suffisant pour que l’offre puisse émerger dans le cadre de projets singuliers ou locaux76, leur visibilité étant effacée par les quelques acteurs transnationaux et généralistes qui, seuls, à quelques exceptions près77, assurent la convergence de données de plus en plus nombreuses, donnant au crowdsourcing un goût amer d’outsourcing revisité, proposant au Monde de produire bénévolement la richesse de quelques-uns, avec pour seule contrepartie le loisir d’en profiter, sans l’assurance que cela puisse durer78. À qui appartiennent les données ? Comment s’assurer de leur utilisation sur d’autres services ? Quel respect de la vie privée ? Comment avoir l’assurance de pouvoir effacer les traces que l’on laisse ? Comment ne pas limiter la géolocalisation à des points au détriment des surfaces ?

En sus du questionnement inhérent à la qualité des images ainsi produites, il convient donc de s’assurer aussi de l’environnement de leur production et de ne pas sous-estimer le poids que prennent actuellement quelques entreprises dans la production des analogies spatiales. Google, en particulier, tend à être sur tous les fronts. Le fond de carte (Google Map, Google Earth), les données géolocalisées (l’ensemble des services qui reposent sur Google Map), les logiciels et systèmes d’exploitation (Google Chrome, Android), la téléphonie mobile (Android, Nexus One) et la recherche, parmi d’autres activités, témoignent bien de l’importance et de la stratégie de Google dans ce domaine. La récente annonce de l’intérêt de Google pour la société Yelp79 ne fait que conforter cette dynamique de concentration des informations spatiales entre les mains d’une entreprise, avec une intensité sans équivalent historique. Jamais une société privée n’eut un tel contrôle sur la production et la circulation de l’information.

« If we understand what is happening, and if we can conceive and explore alternative futures, we can find opportunities to intervene, sometimes to resist, to organize, to legislate, to plan, and to design. » prévenait William Mitchell en 1996 lorsqu’il évoquait la city of bits [Mitchell, 1996, p. 24]. Il n’est pas surprenant que ces propos, mots pour mots, s’appliquent aussi aux maps of bits.

Parce que la carte rend compte de nos existences par les analogies qu’elle offre au regard, elle doit être respectueuse des réalités qu’elle met en image. Parce qu’elle rend lisible notre être au Monde, notre situation, la carte est avant tout un enjeu de représentation de la coexistence, avec laquelle elle se confond souvent dans l’action. L’avenir de la carte est en cela celui de la ville. C’est pourquoi la carte est un enjeu sociétal majeur, qui ne peut faire le pari de l’auto-émergence du sens et de la pertinence des actes qui s’appuieront sur de telles images.